Введение

Под внутренней оптимизацией принято понимать комплекс изменений и доработок ресурса с целью повышения позиций в поисковых системах. Эти действия могут быть направлены на устранение ошибок при загрузке и работе самого сайта, а также факторов, мешающих корректной индексации поисковыми системами.

К изменениям ресурса для повышения позиций относят выбор и оптимизацию целевых страниц под продвигаемые запросы, а также работу над контентом в целом. Как правило, это определенный список стандартных действий (известных каждому). Ведь только благодаря грамотно составленным заголовкам страниц, оптимизации и структуре текстов, тегу title и метатегам можно получить ТОП 10 по большинству НЧ и СЧ запросов и хорошие позиции в ТОП 50 по всему списку продвигаемых запросов. Конечно, результат будет зависеть от профессионализма и опыта оптимизатора, а также от того, какими методами он воспользуется.

Но насколько же эффективны все “стандартные” методы внутренней оптимизации сайта? Может быть, некоторые из них уже устарели и стали неактуальны? А на их место пришли современные приемы, продиктованные постоянным развитием поисковых систем?

В данном материале я попробую обобщить и дать оценку необходимости и эффективности использования стандартных методов внутренней оптимизации.

Какие стандартные действия на самом деле необходимы и для чего

Необходимость многих действий по оптимизации исходит из требований самих поисковых систем Яндекс и Google. Чтобы лучше понимать все нюансы того, каким поисковики представляют себе качественный сайт, который может высоко ранжироваться, стоит изучить следующую информацию:

- Руководство, которое расскажет, как сделать так, чтобы сайт был без ошибок и корректно ранжировался поисковой системой (https://help.yandex.ru/webmaster/).

- Отличия качественного сайта от некачественного (https://help.yandex.ru/webmaster/?id=995342).

- Рекомендации Яндекс.Метрики “Как сделать сайт эффективнее” (https://help.yandex.ru/metrika/recommendations/make-site-better.xml).

- Рекомендации для веб-мастеров от Google (https://support.google.com/webmasters/answer/35769?hl=ru).

Итак, из всех рекомендаций поисковых систем, а также из того, какие выводы из них можно сделать, получается стандартный список действий по оптимизации сайта:

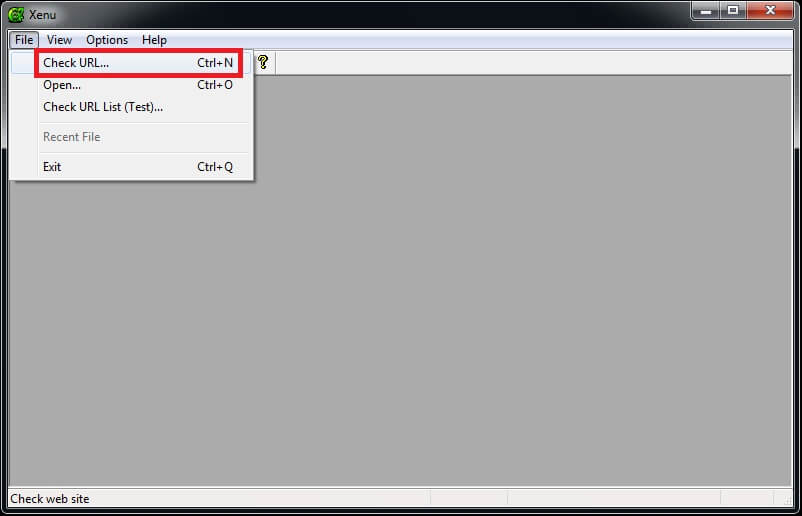

1. Проверка дублей страниц на сайте. Необходима для корректной индексации и ранжирования ресурса в поисковых системах. При наличии дублей сайт может иметь низкие позиции в выдаче. Проверить ресурс на их наличие можно с помощью бесплатной программы Xenu's Link Sleuth. Для этого необходимо в меню “File” выбрать пункт “Check URL” и ввести адрес своего ресурса в первое доступное поле ввода.

Xenu, меню «File», пункт «Check URL»

Результат работы программы можно представить в нескольких вариантах. Для проверки дублей страниц нужно выгрузить отчет, выбрав пункт “Export to TAB separated file” в меню “File”. Результаты будут выгружены в TXT-файл, содержимое которого можно скопировать в Excel. Там будет список всех страниц сайта, на которые стоят внутренние ссылки. Для каждой страницы будет доступно несколько характеристик, в том числе и теги title, description, keywords. По ним и некоторым другим данным, например, одинаковым URL страниц с различными идентификаторами, можно определить дубли страниц.

2.Проверка сайта на наличие “битых” ссылок и их устранение. Если есть “битые” ссылки, ведущие на несуществующие страницы, это может вызвать затруднения у пользователей, и они покинут сайт, так и не найдя необходимую информацию. Так как поисковики в первую очередь стараются высоко оценивать качественные ресурсы, наличие “битых” ссылок негативно повлияет на ранжирование и ухудшит поведенческие факторы. Найти и устранить их также поможет программа Xenu's Link Sleuth. Для этого нужно выгрузить другой вариант отчета, доступный в пункте “Export page map to TAB separated file” в разделе меню “File”. В этом отчете будут представлены все исходящие ссылки с каждой страницы сайта, на которой побывал робот программы. Если какая-то из них ведет на недоступную страницу, то в поле “LinkToPageStatus” будет стоять значение “Not found”. Это и есть “битые” ссылки на определенных страницах.

3. Проверка исходящих ссылок. Наличие большого количества нетематичных исходящих ссылок со страниц сайта воспринимается поисковиками как спам. Из-за этого ресурс не будет высоко ранжироваться. Найти исходящие ссылки на всех страницах можно также с помощью программы Xenu. В отчете, создаваемом при выборе пункта “Export to TAB separated file”, в списке страниц, на которые перешел робот, могут быть другие сайты, ссылки на которые установлены с различных страниц проверяемого ресурса.

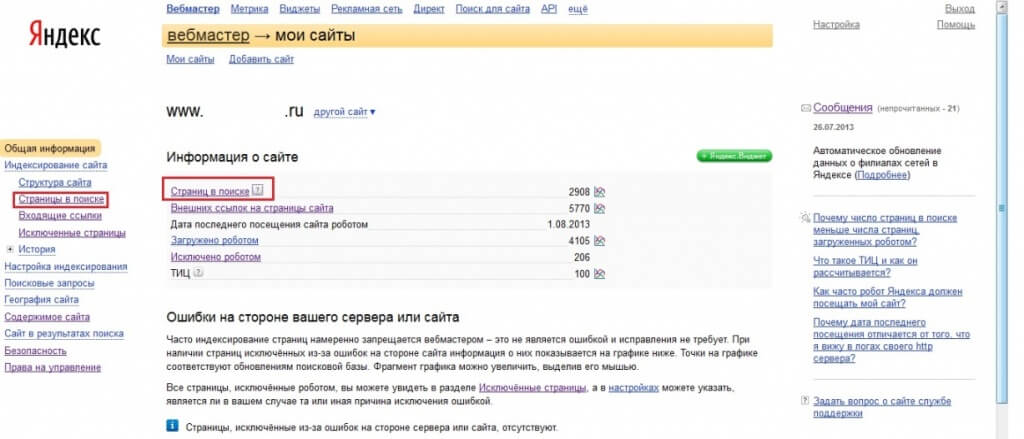

4. Проверка количества проиндексированных страниц. Необходимо знать корректность и количество проиндексированных поисковиками страниц сайта. Если их значительно меньше, чем общее количество страниц, а добавлены они на сайт более 2 месяцев назад, необходимо искать причину, по которой не произошла индексация.

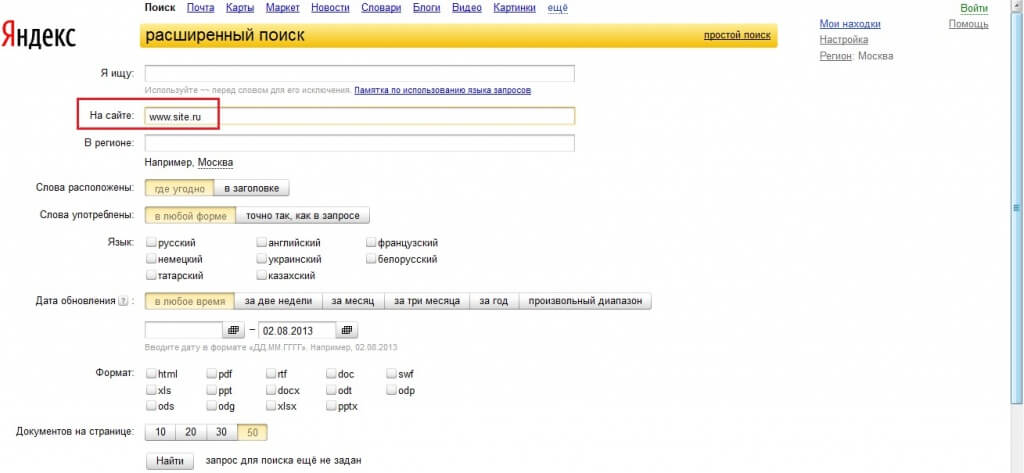

Увидеть количество проиндексированных страниц можно в панели Яндекс.Вебмастера или с помощью расширенного поиска, введя пустой запрос при поиске по своему сайту.

Яндекс.Вебмастер, количество страниц в поиске

Яндекс, расширенный поиск на сайте

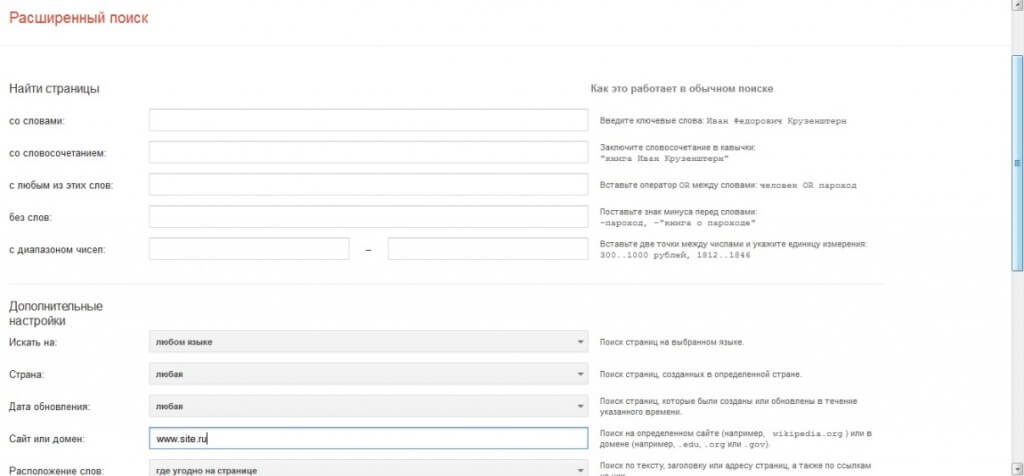

В ПС Google посмотреть количество проиндексированных страниц можно при помощи расширенного поиска, введя пустой запрос и в дополнительных настройках указав свой сайт.

Google, расширенный поиск на сайте

Основных причин неиндексации страниц может быть несколько:

- Малое время, которое прошло с момента добавления страниц. В таком случае стоит подождать 1—2 недели.

- Роботы поисковых систем редко заходят на сайт и индексируют ограниченное количество новых страниц. Чаще всего это происходит потому, что ресурс не обновляется. В таком случае роботам нужно дать понять, что сайт начал развиваться. Необходимо регулярно обновлять контент, добавлять страницы, публиковать новости, отзывы и т.п. Со временем роботы будут чаще посещать ваш ресурс и быстрее индексировать новые страницы.

- На сайт наложен фильтр, или он в “бане” поисковика. В таком случае необходимо найти и устранить причину. Подробнее о наиболее распространенных фильтрах можно узнать в специальных материалах, посвященных фильтрам Яндекса и Google.

5. Устранение проблем хостинга и загрузки сайта. Если страницы долго загружаются и сайт часто недоступен — это одни из признаков некачественного ресурса. Проверить скорость загрузки и мониторить его доступность можно с помощью Яндекс.Метрики в отчете “Результаты проверки”, во вкладке “Мониторинг” (подробнее об отчете).

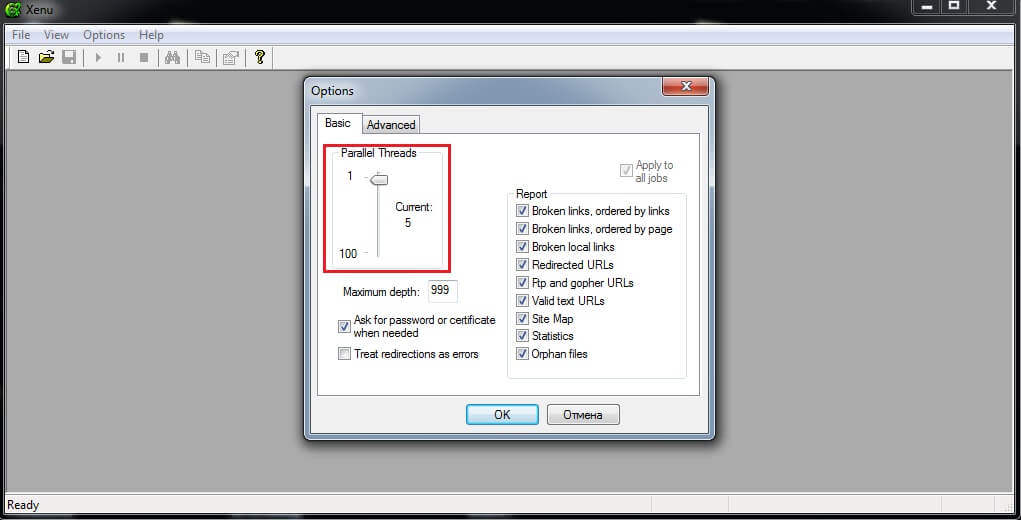

Также оценить работоспособность ресурса при пиковых нагрузках можно с помощью программы Xenu. Для этого необходимо запустить проверку сайта и в настройках указать от 30 и более потоков проверки.

Xenu, настройка количества потоков проверки

6. Оптимизация кода. Под оптимизацией кода обычно понимается удаление из него всех ненужных тегов, вынесение описания стилей и скриптов в отдельные файлы, проверка и настройка валидности кода. Благодаря этому страницы будут быстрее загружаться, что приветствуется поисковиками и пользователями. Эту задачу лучше всего поручить профессиональному программисту или разработчику сайта.

7. Настройка зеркал. Зеркала — это два идентичных сайта, имеющие разные URL. Однако поисковые системы могут посчитать создание таких сайтов “спамными действиями” и наложить на них санкции, поэтому следует произвести правильную настройку зеркал, указав среди них основное (подробнее о настройке https://www.sembook.ru/book/optimizatsiya-sayta-v-detalyakh/nastroyka-redirekta-i-kody-statusa-http/ и https://www.sembook.ru/book/ogranicheniya-dlya-prodvizheniya/neglavnoe-zerkalo/).

8. Настройка корректной индексации разделов сайта в robots.txt, закрытие от индексации части служебных страниц, которые не несут ценности пользователю. Часто системы управления сайтом генерируют так называемые “служебные” страницы, информация на которых может дублироваться, или страницы с идентификаторами сессий. Например, это могут быть различные страницы с сортировками товара по названию или цене. Контент на них повторяет информацию разделов с этими товарами, и они являются дублями для роботов поисковых систем. Чтобы такие страницы-дубли не попадали в индекс, их нужно закрыть от индексации. Обычно для этого используется файл robots.txt (подробнее о его составлении и использовании ).

Заключение

Мы рассмотрели стандартные действия, благодаря которым можно устранить большинство типичных технических ошибок, не позволяющих ресурсу нормально индексироваться и высоко ранжироваться. При начале работ над сайтом проверка по указанным пунктам должна быть проведена одной из первых. Только после этого можно оптимизировать продвигаемые страницы, наполнять сайт, закупать ссылки и выполнять все остальные действия по продвижению. Ведь при наличии технических ошибок или фильтров ресурс просто не будет нормально ранжироваться, каким бы качественным он ни был.

Помимо устранения ошибок, к внутренней оптимизации относится еще ряд действий, благодаря которым сайт будет давать полезные ответы на запросы. О них пойдет речь во 2-ой части статьи о внутренней оптимизации, которая выйдет в следующем выпуске Прожектора Rookee.

Статьи выпуска: